Apify : Le Guide Ultime pour transformer le Web en Base de Données (Scraping & Automatisation)

Tu as besoin de données pour ton SaaS ou tes automatisations ? Oublie les scripts Python qui cassent tous les deux jours. Découvre Apify, la plateforme qui transforme n'importe quel site web en API.

TL;DR : Le web est la plus grande base de données du monde, mais elle est illisible pour tes robots. Apify est la solution pour transformer n'importe quel site (Instagram, Google Maps, LinkedIn) en une API propre et structurée. C'est l'outil indispensable pour tout Builder qui a besoin de données externes.

🔧 Ma Stack Data & Scraping

Voir tous les outilsLes outils que j'utilise pour collecter et exploiter des données web.

Web scraping et automatisation navigateur

Automatisation open-source avancée

Automatisation visuelle sans code

Prospection et scraping de données

Certains liens sont des liens affiliés. Je ne recommande que des outils que j'utilise réellement.

Si tu construis des automatisations (avec n8n ou Make) ou que tu développes ton propre SaaS, tu as forcément rencontré ce mur : l'accès à la donnée.

Tu as besoin des leads de Google Maps ? Il n'y a pas d'API officielle (ou elle coûte une fortune). Tu veux surveiller les prix d'un concurrent ? Ils bloquent ton adresse IP. Tu veux récupérer des profils LinkedIn ? C'est la croix et la bannière.

Pendant longtemps, la solution était de coder tes propres scripts de scraping en Python avec Selenium ou Puppeteer. Et soyons honnêtes : c'est un enfer. Les sites changent leur structure HTML, Cloudflare te bloque, et tu passes plus de temps à réparer tes scripts qu'à utiliser les données.

C'est là qu'intervient Apify.

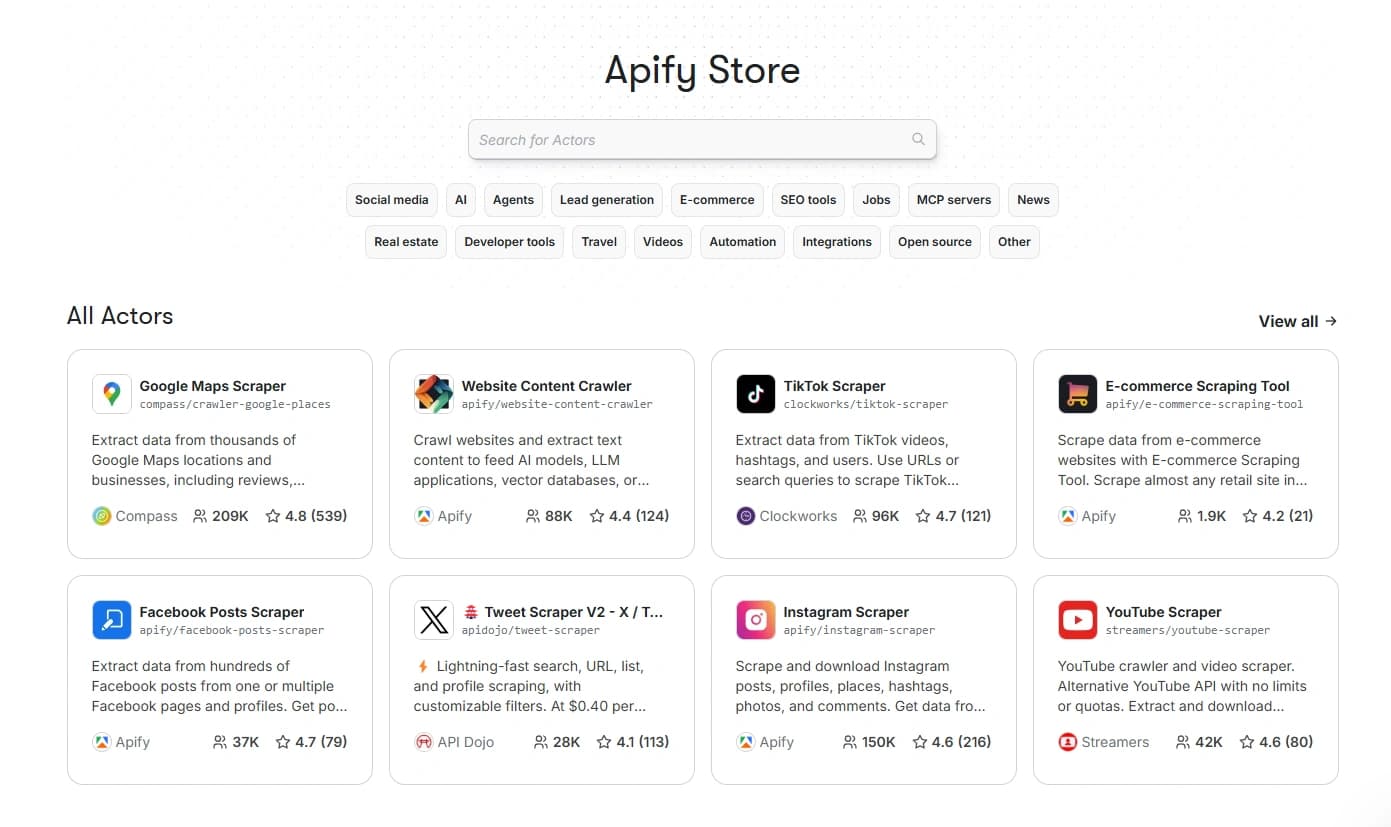

Vois Apify comme l'App Store du Web Scraping. C'est une plateforme Cloud qui héberge des milliers de robots (appelés "Actors") prêts à l'emploi pour extraire de la donnée de n'importe où.

Depuis l'accueil, tu retrouves l'ensemble des Actors d'Apify.

Dans ce guide, je vais te montrer comment je l'utilise pour mes propres projets, notamment pour ResumeRank, où je transforme des profils LinkedIn en données structurées pour l'IA.

1. Apify : C'est quoi exactement ?

Fondée à Prague en 2015 par Jan Čurn et Jakub Balada (et passée par le Y Combinator), Apify est une success story assez rare dans la tech : une croissance monstre autofinancée pendant des années (6,7 millions d'euros de CA en 2023) avant une première levée de fonds en 2024.

Pourquoi ce succès ? Parce qu'ils ont résolu le problème numéro 1 du scraping : l'infrastructure.

Le concept des "Actors"

Sur Apify, un script de scraping ne s'appelle pas un script, c'est un Actor. C'est un programme serverless qui tourne dans le cloud d'Apify.

- Tu es développeur ? Tu peux coder tes propres Actors en Node.js ou Python et les héberger chez eux (ils gèrent les proxys, le stockage, le scaling).

- Tu ne sais pas coder ? C'est là que ça devient génial. Tu as accès au Store, une place de marché avec plus de 5 000 Actors pré-construits par la communauté.

Tu veux scraper Instagram ? Il y a un Actor pour ça. Tu veux les résultats de recherche Amazon ? Il y a un Actor pour ça. Tu n'as qu'à cliquer sur "Run".

La gestion des Proxys (Le nerf de la guerre)

Le scraping, c'est 20% de code et 80% de gestion d'IP pour ne pas se faire bannir. Apify inclut une gestion native des proxys (Residentiels, Datacenter). Quand tu lances un Actor, il gère lui-même la rotation des IP pour passer inaperçu.

2. Prise en main : Ton premier scraping en 5 minutes

Pas besoin de sortir le terminal. On va faire ça ensemble.

Étape 1 : Créer un compte et explorer le Store

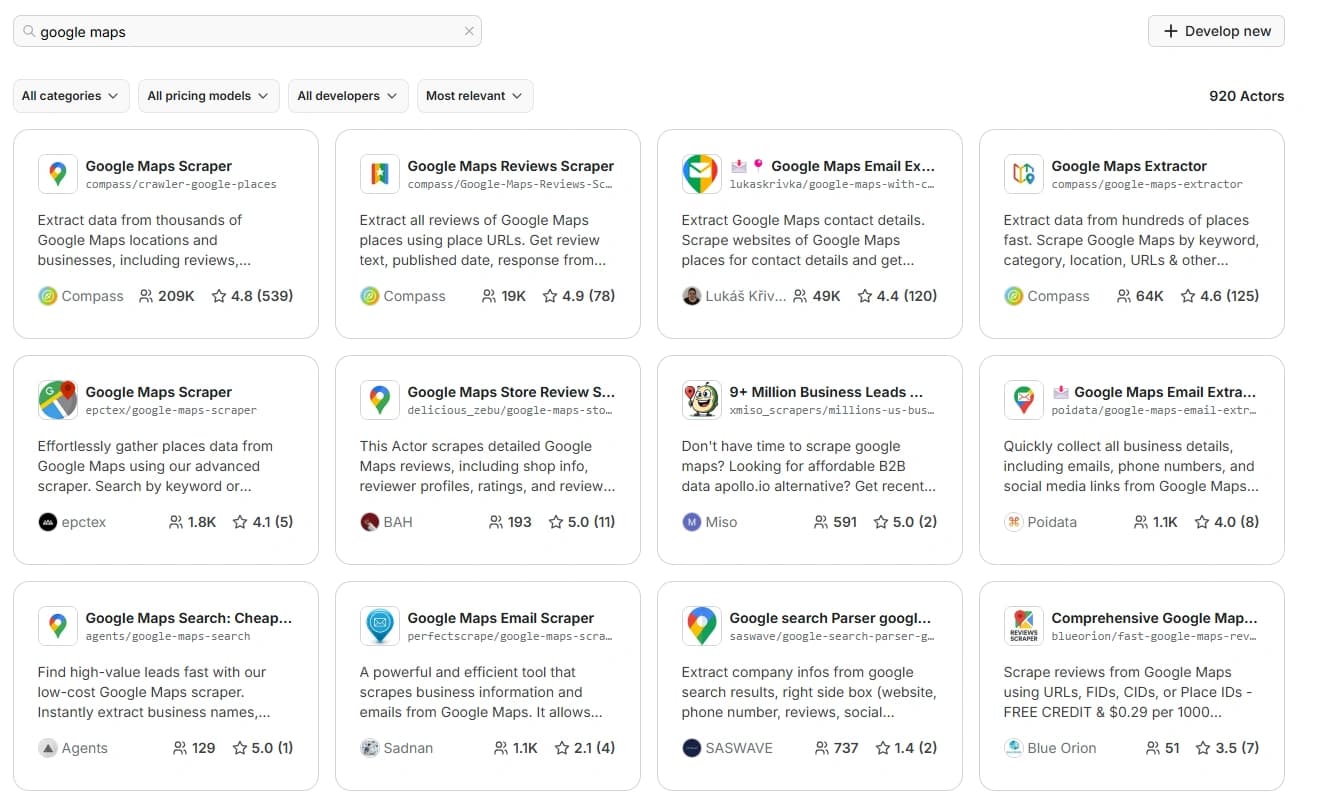

Rends-toi sur Apify et crée ton compte gratuit. Une fois connecté, va directement dans l'onglet Store. C'est ta caverne d'Ali Baba. Tape "Google Maps" dans la barre de recherche.

De nombreux devs ont codé des scrapers Google Maps, à toi de prendre le plus populaire et le tester.

Étape 2 : Configurer l'Input

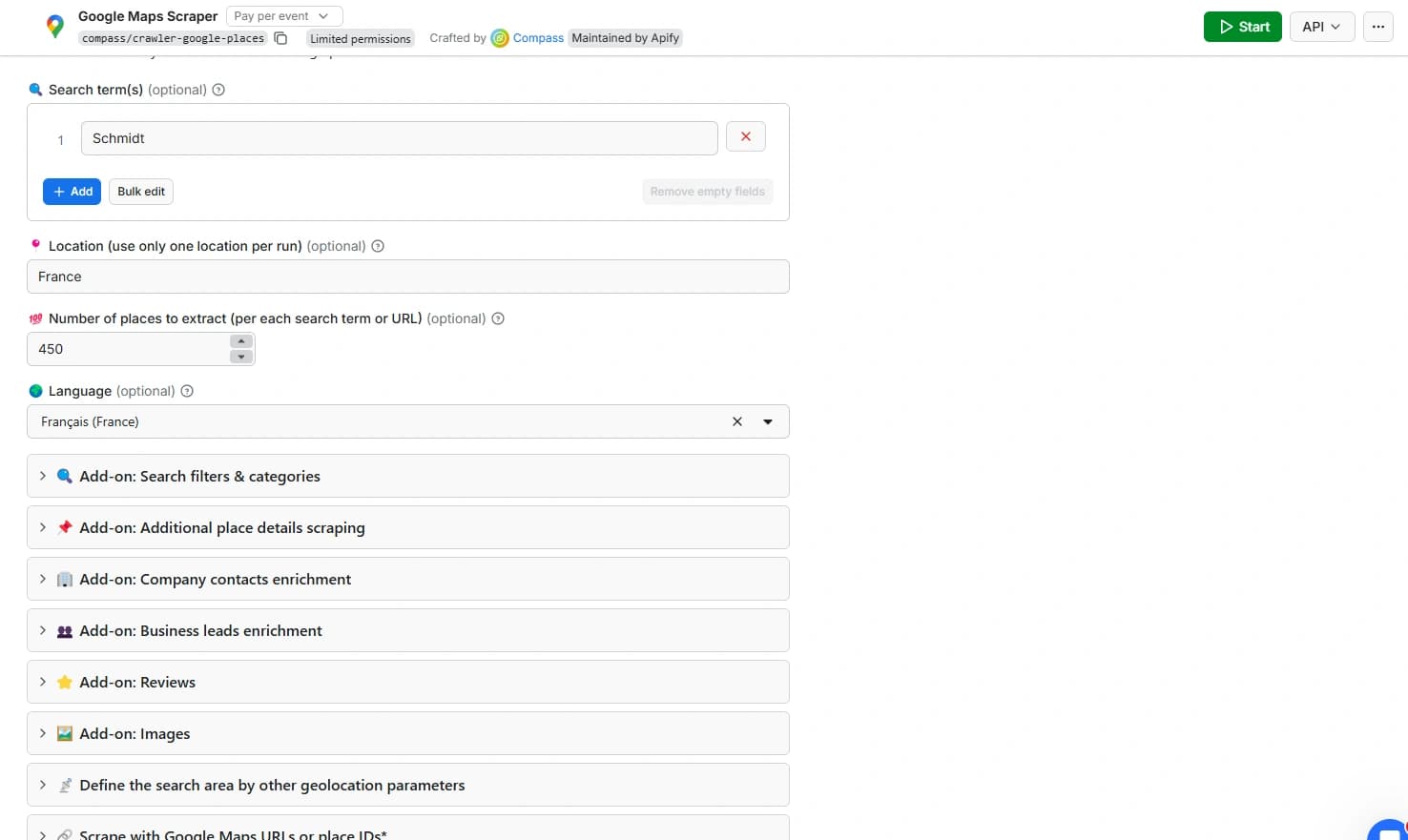

Tu vas tomber sur "Google Maps Scraper". Clique dessus. L'interface est super bien faite. Au lieu de voir du code, tu vois des formulaires.

Par exemple, si tu veux scraper tous les magasins Schmidt de France.

Apify te demande simplement :

- Search terms : "Schmidt"

- Max items : Combien de résultats tu veux ? (Disons 450).

- Language : Français.

Tu peux ensuite ajouter des add-ons pour récupérer les notes Google Maps, des images, récupérer l'url du site et scraper le contenu du site, etc.

Étape 3 : Run & Data

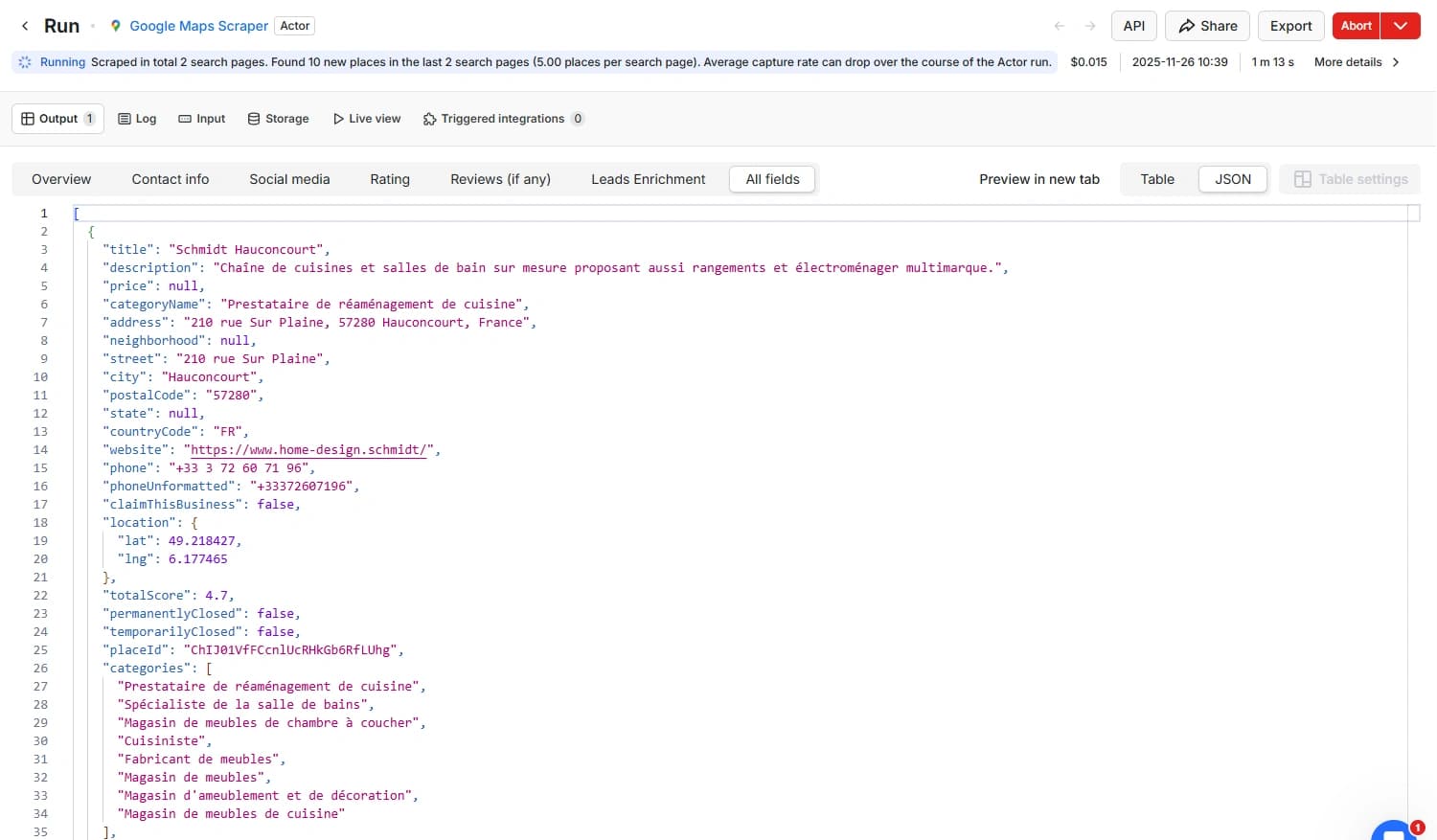

Clique sur le gros bouton vert Start. Tu vas voir une console s'ouvrir. C'est l'Actor qui lance un navigateur headless (sans interface graphique), va sur Google Maps, tape ta recherche et commence à scroller.

En quelques secondes, tu vas voir les résultats apparaître dans l'onglet Dataset. Tu peux exporter ça en Excel, JSON, CSV, ou XML.

Voici l'exemple du résultat d'un scrap sous forme de JSON.

🎯 L'API est la clé

C'est bien beau d'avoir un Excel, mais la vraie puissance d'Apify, c'est son API. Chaque Actor que tu configures possède une URL API unique. Tu peux donc appeler ce scraping depuis n8n, Make, ou ton propre code, et recevoir les données en JSON directement dans ton application.

3. Le Top 5 des Actors les plus puissants

Il y a des milliers d'Actors, mais certains sont des incontournables qui peuvent littéralement porter un business entier. Voici ceux qui dominent la plateforme :

1. Instagram Scraper

C'est l'outil de veille ultime. Il te permet d'extraire des profils, des posts, des commentaires ou des hashtags. Cas d'usage : Tu lances une marque de vêtements ? Tu peux scraper tous les followers d'un concurrent pour analyser leur bio, ou récupérer tous les posts avec le hashtag #ModeResponsable pour identifier des influenceurs.

2. Google Maps Scraper

La machine à Lead B2B. C'est probablement l'Actor le plus utilisé pour la prospection locale. Il ne récupère pas juste le nom et l'adresse. Il récupère les horaires, les notes, les avis, et parfois l'email s'il est visible. Cas d'usage : Constituer une base de données de tous les artisans d'une région pour leur proposer tes services.

3. TikTok Scraper

L'analyse de viralité. TikTok est une boîte noire, mais cet Actor te permet d'en sortir les données. Tu peux récupérer les métriques d'engagement, les sons tendances, ou les profils utilisateurs sans te connecter. Cas d'usage : Détecter une trend musicale avant tout le monde pour créer du contenu viral.

4. Twitter (X) Scraper

L'analyse d'opinion en temps réel. Même si l'API officielle de X est devenue très chère, les scrapers Apify (comme celui d'API Dojo) continuent de fonctionner pour récupérer des tweets par mots-clés ou profils. Cas d'usage : Faire de l'analyse de sentiment sur le lancement d'un produit ou surveiller sa e-réputation.

5. Website Content Crawler

Le couteau suisse pour l'IA. C'est l'Actor parfait pour alimenter tes modèles LLM, tes bases de données vectorielles ou tes pipelines RAG. Il crawle n'importe quel site, extrait le contenu textuel propre (en Markdown), et s'intègre nativement avec LangChain et LlamaIndex. Cas d'usage : Créer une base de connaissances à partir de la documentation d'un outil, ou entraîner un chatbot sur le contenu d'un site concurrent.

4. Cas Pratique : Comment je booste ResumeRank avec Apify

La théorie c'est bien, mais voyons comment ça s'intègre dans un vrai produit SaaS. Si tu suis mon aventure Build in Public, tu sais que je construis mon premier Micro-SaaS en parallèle de mon job.

Pour mon projet ResumeRank (un outil qui analyse les CV grâce à l'IA), j'avais un problème : le CV est un document statique. Souvent, les candidats ne mettent pas tout et embelissent même leurs CVs. Ils oublient leurs dernières certifications, leurs recommandations, ou s'inventent des responsabilités qu'ils n'avaient pas.

Or, où se trouve l'information la plus à jour ? Sur LinkedIn.

Le Workflow "Enrichissement de Candidat"

J'ai mis en place une automatisation qui permet de scanner le profil LinkedIn du candidat pour donner plus de contexte à l'IA. Voici comment ça marche sous le capot :

Étape 1 : Le déclencheur

Lorsqu'un chargé de recrutement ou RH soumet le CV du candidat sur ResumeRank, je détecte sur le CV si il y a une URL LinkedIn.

Étape 2 : L'appel à Apify

ResumeRank envoie une requête à l'API d'Apify et plus précisément l'actor LinkedIn Scraper. J'utilise un Actor spécifique de scraping de profils LinkedIn (il en existe plusieurs très performants comme le Mass Linkedin Profile Scraper with Email).

Note : Pour scraper LinkedIn, il faut souvent fournir des cookies de session valides. C'est un point technique un peu sensible, mais Apify propose des solutions sécurisées pour gérer ça.

Étape 3 : L'extraction de données

L'Actor navigue sur le profil et me renvoie un JSON ultra-complet contenant :

- La photo de profil HD (pour personnaliser le rapport).

- Le titre actuel (Headline).

- Le résumé (About).

- La liste détaillée des expériences avec les descriptions.

- Les compétences, certifications et langues.

- Les recommandations d'anciens collègues / managers.

Étape 4 : L'analyse IA

Je récupère ce JSON, je le combine avec le texte extrait du PDF du CV, et j'envoie le tout à mon modèle LLM (GPT-5.1 ou Mistral).

Le résultat ? L'IA peut dire au recruteur : "Attention, il y a une incohérence de plusieurs mois entre l'expérience sur le CV et celle de LinkedIn"

Sans Apify, construire ce scraper m'aurait pris des semaines de maintenance. Là, c'est un simple appel API.

💡 Tu veux voir ma stack technique complète ? J'ai détaillé tous mes outils dans l'article Ma Stack et Mon Workflow pour Construire un SaaS en Solo.

5. Combien ça coûte ? (Le piège à éviter)

Apify fonctionne avec un modèle freemium, mais attention à la facture si tu scales.

- Le forfait Plateforme : Il y a un plan gratuit (5$ de crédits/mois), mais pour un usage sérieux, tu passeras vite au plan Starter à 39$/mois.

- Le coût d'usage : Tu payes à la consommation de RAM et de CPU de l'Actor.

- Le coût des Proxys : C'est souvent là que ça chiffre. Pour des sites difficiles comme Instagram ou Google, tu dois utiliser des Proxys Résidentiels (qui coûtent plus cher au Go de bande passante).

⚠️ Optimise tes Actors

Tous les Actors ne se valent pas. Certains sont codés "avec les pieds" et consomment beaucoup de ressources pour rien. Regarde toujours le coût estimé pour 1000 résultats avant de lancer un batch de 100 000 lignes. Fais toujours un petit test avant de scaler.

Conclusion : Le Web est ton API

Ce qu'il faut retenir, c'est qu'Apify fait sauter la barrière technique de l'accès à la donnée. Tu n'as plus besoin d'attendre qu'un site propose une API officielle. S'il est sur le web, tu peux l'utiliser dans tes workflows.

Que ce soit pour de la veille, de la lead gen ou comme moi pour enrichir un produit SaaS, c'est une brique fondamentale de la stack du Solo Builder.

Tu as une idée de projet qui nécessite des données ?

🎯 Ton Toolkit Solo Builder Personnalisé

Tu as une idée de Micro-SaaS mais tu ne sais pas par où commencer ? J'ai créé un simulateur gratuit qui analyse ton projet et te génère une roadmap complète avec les outils adaptés.

📋 Roadmap

Les étapes concrètes pour ton MVP.

🛠️ Stack Outils

Apify, n8n, Make... les bons outils pour ton projet.

💰 Budget

Une estimation réelle des coûts.

🚀 Générer Mon Toolkit Personnalisé

Gratuit • Résultat immédiat • Basé sur 50+ projets réels

📚 Pour aller plus loin

- Guide n8n : Découverte des bases de l'automatisation - Connecte Apify à tes workflows

- Ma Stack Solo Builder - Tous mes outils pour créer un SaaS

- Build in Public #1 : L'histoire de ResumeRank - Comment j'utilise Apify en production

- Voir tous mes outils recommandés - Avec les liens pour démarrer