Apify en 2026 : Le Guide Complet

Transforme n'importe quel site web en base de donnees structurees. Avis, pricing, cas d'usage concrets et comparatif vs PhantomBuster.

Apify est-il fait pour toi ?

Apify est pour toi si...

- Tu as besoin de donnees web pour ton SaaS ou ta prospection

- Tu veux scraper Google Maps, LinkedIn, Amazon ou n'importe quel site

- Tu cherches des robots prets a l'emploi (pas besoin de coder)

- Tu veux automatiser la collecte de donnees a grande echelle

- Tu utilises deja Make ou n8n et tu veux les alimenter en donnees

- Tu construis un Micro-SaaS qui a besoin de donnees externes

Apify n'est PAS pour toi si...

- Tu cherches uniquement a prospecter sur LinkedIn

- Tu n'as pas besoin de donnees web externes

- Tu veux juste automatiser des taches (sans scraping)

- Tu as un budget tres serre (moins de 29$/mois)

Alternatives : Pour la prospection LinkedIn, PhantomBuster est plus adapte. Pour l'automatisation sans scraping, n8n ou Make.

Qu'est-ce qu'Apify ?

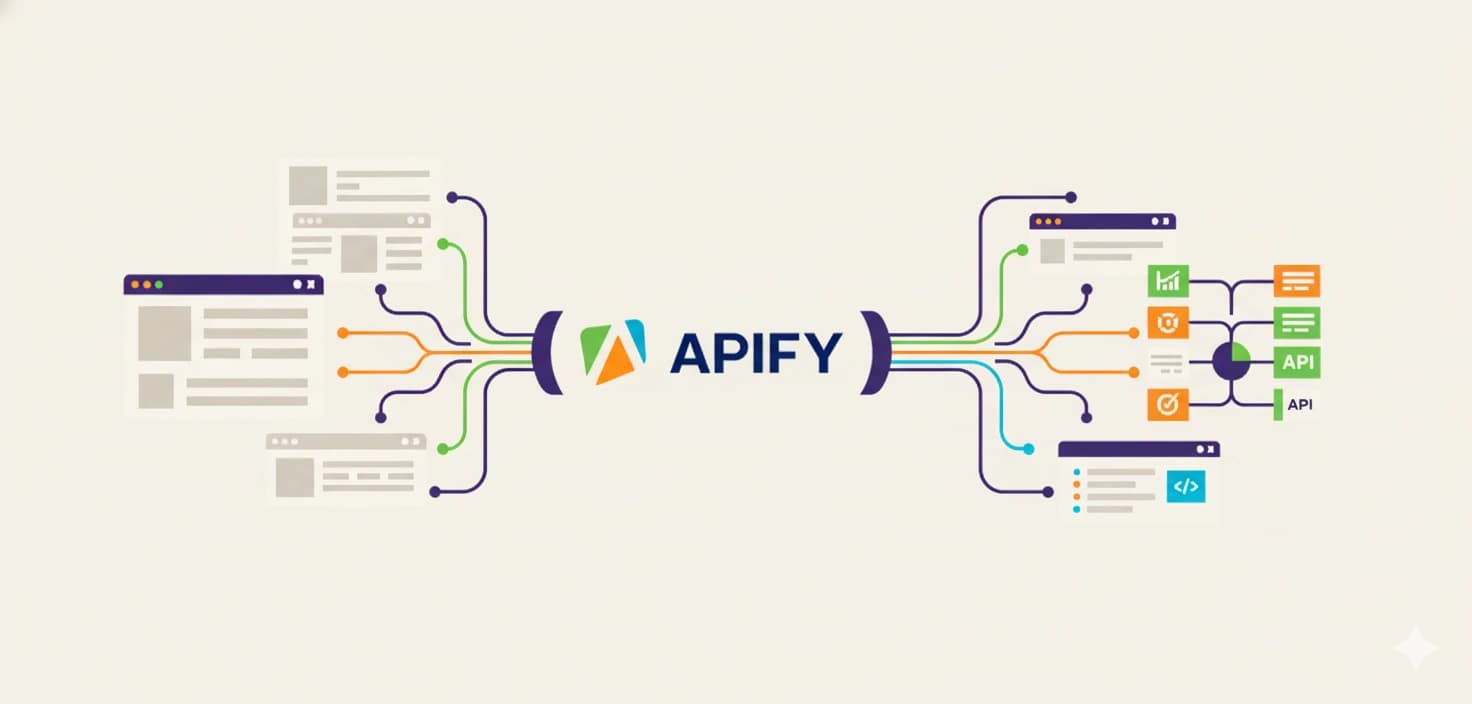

Apify resout un probleme simple : transformer le web en API. Des plateformes comme Google Maps, Instagram ou LinkedIn sont d'immenses bases de donnees, mais elles ne souhaitent pas toujours que vous y accediez librement. Apify permet de creer une API “maison” via le scraping, pour acceder a ces donnees de maniere structuree.

Sa force : une marketplace de 2000+ Actors (des robots serverless qui tournent dans le cloud). Chaque Actor est un programme specialise -- Instagram Scraper, Google Maps Extractor, Twitter Scraper... Tu n'as qu'a configurer les parametres et cliquer sur “Run”. Et si aucun Actor ne correspond a ton besoin, tu peux creer le tien avec le framework open-source Crawlee (JavaScript ou Python), meme avec l'aide de ChatGPT.

Pour les Solo Builders, Apify est la piece manquante du puzzle : il alimente tes workflows Make/n8n en donnees fraîches, enrichit ta prospection, et te permet de construire des Micro-SaaS bases sur des donnees web. Et la vraie puissance, c'est l'API : chaque Actor que tu configures possede une URL API unique que tu peux appeler depuis n'importe quel outil.

Les 3 concepts cles a comprendre

- Actor : Un programme serverless qui tourne dans le cloud d'Apify. C'est ton scraper ou crawler -- l'outil qui va chercher la donnee.

- Task : Une configuration sauvegardee d'un Actor. Par exemple, “Rechercher des restaurants a Paris” sur le Google Maps Scraper.

- Dataset : L'endroit ou sont stockees les donnees extraites. Exportable en JSON, CSV, Excel, ou consommable via API.

Combien coute Apify en 2026 ?

Forfait mensuel + pay as you go. Credits prepaid inclus, depassement facture.

Free

Gratuit

5$ de credits prepaid/mois

- 5$ de credits prepaid/mois

- 0.30$/Compute Unit

- 8 Go de RAM max

- 25 runs simultanees

- 5 IP datacenter incluses

- Apify Store + API REST

- Support communaute uniquement

- Credits non reportables

- Acces bloque si depassement

Ideal pour : Decouverte et tests

Essayer FreeStarter

29$/mois

+ pay as you go (29$ de credits prepaid)

- 29$ de credits prepaid/mois

- 0.30$/Compute Unit

- 32 Go de RAM max

- 32 runs simultanees

- 30 IP datacenter incluses

- Support chat

- Reduction Bronze sur le Store

- Depassement facture sur la prochaine facture

Ideal pour : Solo Builders pour demarrer

Essayer StarterScale

199$/mois

+ pay as you go (199$ de credits prepaid)

- 199$ de credits prepaid/mois

- 0.25$/Compute Unit (reduit)

- 128 Go de RAM max

- 128 runs simultanees

- 200 IP datacenter incluses

- Support chat prioritaire

- Reduction Silver sur le Store

- 1h de formation/trimestre

Ideal pour : Equipes et usage regulier

Essayer ScalePremier scraping en 12 minutes

De zero a tes premieres donnees en 4 etapes

Creer un compte

2 minInscris-toi sur Apify. Tu recois 5$ de credits gratuits pour tester.

Choisir un Actor

3 minParcours la marketplace et choisis un Actor (ex: Google Maps Scraper, LinkedIn Scraper).

Configurer et lancer

5 minRemplis les parametres (URL, mots-cles, limites) et lance ton premier scraping.

Exporter les donnees

2 minRecupere tes donnees en JSON, CSV ou Excel. Ou connecte un webhook vers Make/n8n.

Que peut-on scraper avec Apify ?

6 cas d'usage concrets avec les Actors les plus populaires

Cold Email automatise (B2B)

Scrape des restaurants/artisans sur Google Maps, verifie s'ils ont un site, trouve l'email via enrichissement, puis genere un email de prospection personnalise avec l'IA. Pipeline complet Apify + Make + GPT.

Enrichissement LinkedIn pour SaaS

Scrape les profils publics LinkedIn pour enrichir les donnees de tes utilisateurs. C'est exactement ce que fait ResumeRank : on detecte l'URL LinkedIn sur le CV et on recupere headline, experiences, certifications via l'API Apify.

Veille Instagram et TikTok

Extraire les posts, commentaires, metriques d'engagement et profils de concurrents ou influenceurs. Ideal pour detecter les trends avant tout le monde ou analyser l'audience d'un concurrent.

Base de connaissances pour IA (RAG)

Le Website Content Crawler extrait le contenu textuel propre (en Markdown) de n'importe quel site. Ideal pour alimenter des bases vectorielles, des pipelines RAG ou entrainer un chatbot sur de la documentation.

Veille prix Amazon/e-commerce

Surveille automatiquement les prix, avis et classements de tes concurrents. Configure un Schedule pour lancer le scraping chaque matin et recevoir les alertes dans Slack via Make/n8n.

Analyse du marche de l'emploi

Scrape Indeed ou LinkedIn Jobs pour des postes specifiques, recupere la description complete, puis utilise l'IA pour personnaliser ton CV pour chaque offre automatiquement.

Configuration avancee

Les fonctionnalites qui font la difference a grande echelle

Proxies intelligents

Le scraping, c'est 20% de code et 80% de gestion d'IP. Apify gere automatiquement la rotation des proxies.

- Datacenter : rapides et pas chers, mais detectables

- Residentiels : IP de vrais utilisateurs, tres difficiles a bloquer

- SERP : specialises pour Google Search

Schedules (plannings)

Indispensable pour la veille. Definis une frequence (ex: “Tous les lundis a 9h”) pour lancer un Actor automatiquement. Cela permet de creer des bases de donnees qui s'actualisent seules.

Combine avec un webhook vers Make/n8n pour un pipeline 100% automatique.

Storage et retention

Les donnees sont stockees dans des Datasets exportables (JSON, CSV, Excel). Attention : par defaut, les donnees sont supprimees apres 7 jours.

Astuce : renomme tes Datasets pour les conserver plus longtemps, ou exporte automatiquement vers Airtable/Supabase.

Monetiser ses propres Actors

Apify n'est pas seulement un outil pour consommer des donnees. Tu peux aussi en vendre.

Si tu crees un Actor utile (ex: un scraper pour un site de niche immobilier, un extracteur de donnees specifique a ton industrie), tu peux le publier sur le Store Apify et le monetiser :

- Abonnement mensuel (Rental) : les utilisateurs paient pour acceder a ton Actor

- Pay per result : facturation a l'utilisation (ex: 2$/1000 resultats)

- Apify prend ~20% de commission, tu gardes le reste

Certains createurs sur la plateforme generent plusieurs milliers de dollars par mois en revenus passifs simplement en maintenant des Actors populaires. Un vrai side-business pour les Solo Builders techniques.

Creer son propre Actor (meme sans coder)

Si aucun Actor du Store ne correspond a ton besoin, tu peux creer le tien.

Creer un Actor

Development > Create Actor. Choisis un template (JS + Cheerio pour du scraping simple et rapide).

L'astuce low-code

Copie le code par defaut et colle-le dans ChatGPT avec un prompt du type : "Ce code recupere les titres H1. Modifie-le pour qu'il recupere la Meta Description et les paragraphes."

Build et test

Colle le code modifie dans l'editeur Apify, clique sur Build puis Start. Verifie l'onglet Output.

Publier (optionnel)

Si ton Actor est utile, publie-le sur le Store et monetise-le avec un modele Rental ou Pay per result.

Apify vs PhantomBuster vs Scrapy

Le comparatif pour choisir ton outil de scraping

| Critere | Scrapy | ||

|---|---|---|---|

| Specialite | Scraping generaliste | Prospection sociale | Framework code |

| Marketplace | 2000+ Actors | 100+ Phantoms | Aucune |

| No-code | Oui (Actors) | Oui | Non (100% code) |

| Code custom | JS + Python (Crawlee) | Non | Python |

| Oui | Specialiste | Difficile | |

| Google Maps | Specialiste | Limite | Possible |

| Proxies inclus | Oui (plans payants) | Oui | Non |

| Integration Make/n8n | Native | Via API | Manuelle |

| Prix d'entree | Gratuit (5$ credits) puis 29$/mois | 56€/mois | Gratuit (code) |

Le combo gagnant : Apify + n8n

Apify scrape les donnees, n8n ou Make les transforme et les envoie vers ton CRM, ta base de donnees ou ton outil d'emailing.

Le workflow asynchrone en 3 etapes (methode recommandee)

La methode synchrone (un seul appel HTTP) timeout sur les scrapes longs. La bonne approche est asynchrone :

Trigger

Schedule / Webhook

HTTP POST

Start Actor

Wait

~25 secondes

HTTP GET

Fetch Dataset

1. Demarrer (POST)

Envoie la config JSON a l'endpoint “Run Actor”. Tu recois un statut RUNNING.

2. Attendre (Wait)

Verifie le temps moyen dans l'onglet Runs d'Apify et ajoute une marge.

3. Recuperer (GET)

L'endpoint “Get last run dataset items” renvoie les donnees en JSON.

Tableau vide ? Le Wait etait trop court. Verifie l'onglet Runs dans Apify.

Guides et Tutoriels Scraping

Apprends a maitriser Apify et le web scraping

Questions Frequentes sur Apify

Pret a transformer le web en donnees ?

Commence gratuitement avec 5$ de credits offerts. Ton premier scraping Google Maps en 12 minutes.

Lien partenaire -- je ne recommande que des outils que j'utilise.

Rejoins 2000+ Solo Builders

Recois chaque semaine mes meilleurs conseils sur le scraping, l'automatisation et la creation de Micro-SaaS.

Gratuit. Désinscription facile.